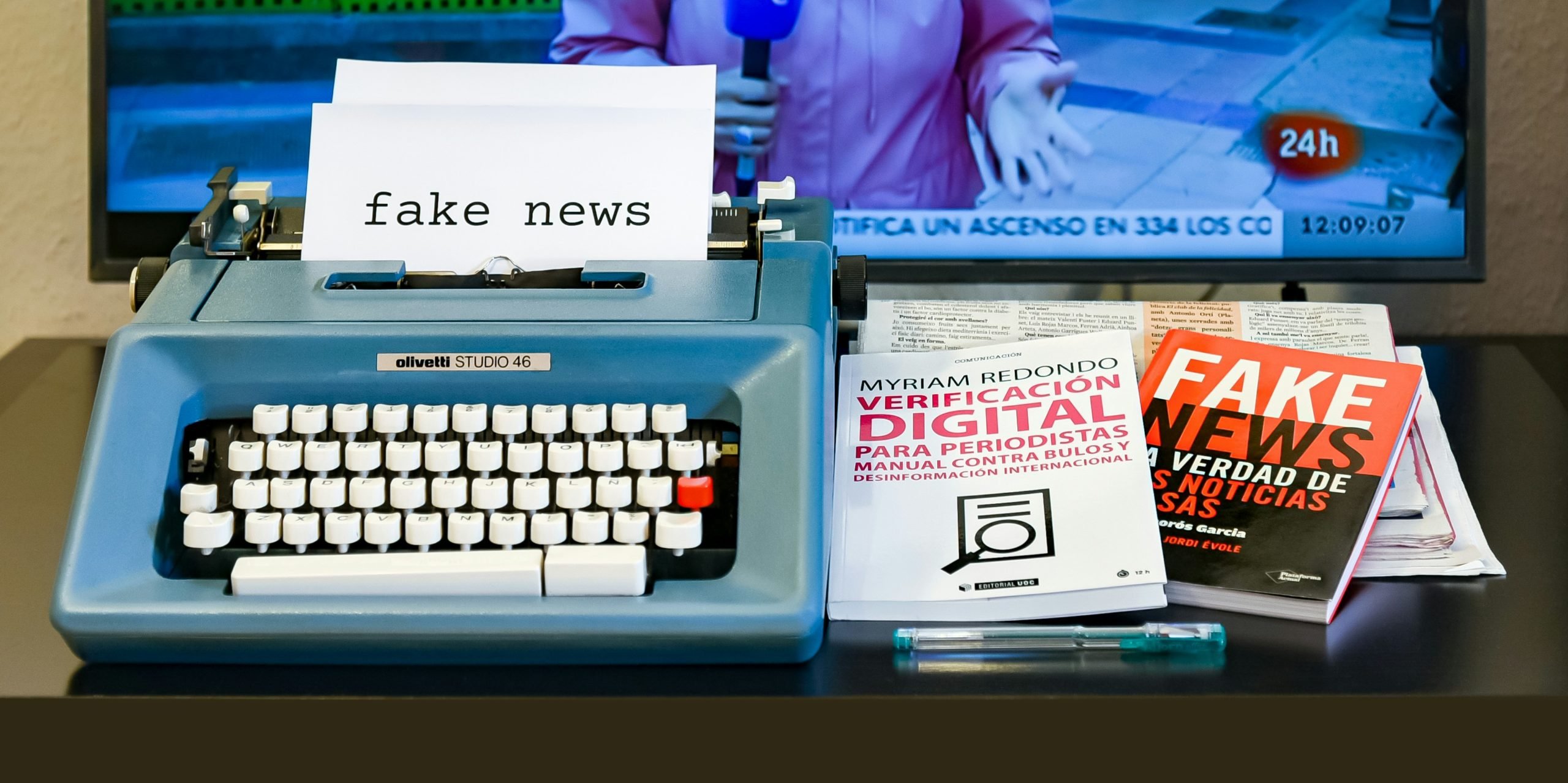

La polarización y las acusaciones cruzadas han dado forma a la desinformación de la guerra entre Israel y Hamás, origen principal de las falsedades difundidas en 2023, un año en el que el impacto negativo de los engaños con inteligencia artificial (IA) fueron menor de lo esperado.

Expertos consultados por EFE destacan el acusado carácter ideológico de las narrativas desinformativas de la guerra en Gaza para inclinar la balanza de la opinión pública en favor de un lado u otro.

Coinciden, asimismo, en que la inteligencia artificial no se ha revelado todavía como un gran impulsor de contenidos falsos, aunque advierten acerca de la necesidad de mantener una vigilancia constante sobre esta tecnología.

El conflicto en Gaza desencadenó una “guerra de narrativas” entre los contendientes que busca “demonizar al adversario” y “reforzar la adhesión internacional a su causa”, afirma Ramón Salaverría, coordinador de Iberifier, un observatorio de desinformación de España y Portugal que reúne a verificadores e investigadores académicos.

Los contenidos de desinformación, comenta el también catedrático de Periodismo de la Universidad de Navarra (España), han estado impulsados en gran medida desde fuera de Israel y Gaza, por países y actores “con intereses políticos”.

“Si la guerra entre Israel y Hamás ha sido local, la desinformación derivada ha sido global”, subraya Salaverría.

Según los datos recopilados por el Observatorio Europeo de Medios Digitales (EDMO), la guerra en Gaza ha sido el evento que más desinformación generó desde abril de 2022, cuando la invasión de Ucrania protagonizó casi la mitad de los contenidos falsos detectados.

La “extrema polarización” y la existencia “de una posición ideológica muy fuerte” moldeó la difusión de falsedades en torno a este conflicto, señala por su parte el coordinador de Verificación del EDMO, Tommaso Canetta.

Canetta apunta a que las principales narrativas buscaron “deshumanizar al enemigo”, así como “negar” o “exagerar” los horrores de un bando u otro.

Ejemplo de ello son las numerosas publicaciones que en redes sociales extendieron el término “Pallywood” -que fusiona las palabras “Palestina” y “Hollywood”- para acusar al pueblo palestino de difundir supuestas imágenes de víctimas falsas, mientras que, en el caso de Israel, distintos internautas le imputaron crímenes de guerra que no cometió.

Te recomendamos: Editores de prensa piden revisión de la nueva ley de inteligencia artificial

Expertos advierten de una posible oleada de falsedades creadas por IA

Entre tanto, otro conflicto, el de la guerra de Ucrania, también marcó la propagación de falsedades en 2023, si bien, el gran flujo que caracterizó el inicio de la invasión rusa fue menguando hasta estancarse este año, según constata el EDMO.

El vertiginoso desarrollo que la IA experimentó este año, con la aparición de multitud de herramientas que la hicieron aún más accesible al público, acrecentó el temor por su posible implicación en la creación y difusión de falsedades, aunque los expertos evitaron desde el principio caer en el pesimismo.

Por el momento “las falsedades generadas por IA siguen careciendo del volumen y la sofisticación que muchos esperaban”, afirma Angie Drobnic Holan, directora de la Red Internacional de Verificación (IFCN, por sus siglas en inglés), que reúne a medios especializados de todo el mundo, entre ellos EFE Verifica.

Como señala Holan, las falsedades creadas mediante esta tecnología son inferiores a otras tácticas más antiguas, como la difusión de imágenes fuera de contexto, la manipulación digital o las “falsificaciones baratas”.

Del mismo modo, Salaverría coincide en que todavía no se experimentó una gran “ola de falsificaciones con esas herramientas”, pero pide estar preparados para una gran “marea de contenidos falsificados” mediante IA que “todo apunta a que más pronto que tarde llegará más desinformación”.

Por su parte, Canetta explica que la calidad de estos contenidos, sobre todo de las imágenes, permite por el momento descubrirlos con bastante facilidad, aunque precisa que este año se detectó algún ejemplo preocupante.

En concreto, menciona un caso ocurrido en Eslovaquia, donde dos días antes de las elecciones generales de septiembre circuló una falsa grabación en la que se simuló la voz del candidato progresista para acusarle de una supuesta compra de votos.

“Los contenidos generados por IA deben estar bajo vigilancia constante (y estarán, con EDMO), porque creemos que potencialmente pueden crear enormes problemas en el futuro, cuando la tecnología evolucione”, remarca Canetta.

Asimismo, elecciones de distintos países se vieron afectados por campañas de desinformación que cuestionaban la credibilidad de sus sistemas electorales.

Fue el caso de Brasil, donde el año comenzó con el asalto a las sedes de los tres poderes, mientras que en Argentina estas teorías reaparecieron en la primera vuelta de los comicios presidenciales promovidas por simpatizantes del candidato Javier Millei.

En España, las elecciones autonómicas y municipales en mayo y las generales de julio también estuvieron marcadas por la proliferación de mensajes que extendían sospechas sobre el voto por correo o la manipulación del censo.

Pese a todo, Holan destaca varios puntos positivos en la lucha contra la desinformación este año. “Tanto los verificadores como el público son cada vez mejores a la hora de anticiparse a la desinformación y hacerse fuertes frente a ella. El desmentido es más frecuente y rápido”, dice.

Con información de EFE

Síguenos en Google Noticias para mantenerte siempre informado