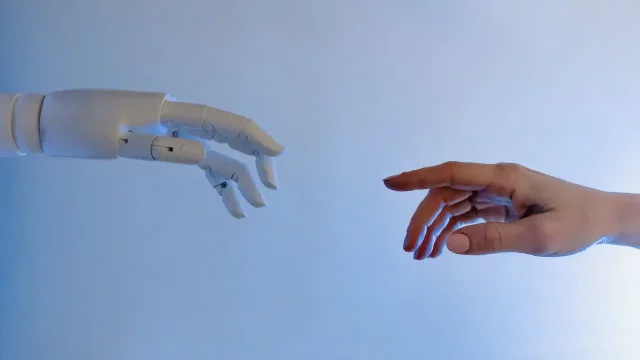

Las industrias creativas y artísticas se han visto amenazadas con el boom de la inteligencia artificial generativa. Los algoritmos están mejorando su capacidad de generar imágenes, música, poesía, fotografías y otros tipos de arte de forma automatizada, personalizada, rápida, masiva y cada vez con mayor calidad, lo que supone una amenaza para artistas y diseñadores.

Pero los artistas no se han cruzado de brazos. Recientemente se dio a conocer Nightshade, una herramienta con la que los creativos buscan sabotear el entrenamiento de los modelos de inteligencia artificial generativa que usan sus obras, sin permiso y mucho menos retribución, para perfeccionarse a sí mismos. Es como si los artistas envenenarán sus obras para romper a la IA.

MIT Technology Review obtuvo un adelanto exclusivo de la investigación que dio origen a Nightshade, misma que se ha sometido a revisión por pares en la conferencia de seguridad informática Usenix.

Lee también: Empresas y no academia llevan las riendas de la inteligencia artificial, alerta la UNAM

La herramienta permite a los artistas añadir cambios invisibles a los píxeles de sus obras antes de subirlas a internet y así, si se integran a un conjunto de datos para entrenar una inteligencia artificial, podría dañar futuras iteraciones de modelos de IA generadores de imágenes, como DALL-E, Midjourney y Stable Diffusion, haciendo que algunos de sus resultados sean alucionaciones, como convertir perros en gatos, coches en vacas.

La investigación detrás de Nightshade fue dirigida por Ben Zhao, profesor de la Universidad de Chicago, Estados Unidos. Su objetivo es equilibrar la balanza en favor de los artistas humanos y disuadir la violación de derechos de autor y propiedad intelectual que puede suponer el usar obras creadas por personas para entrenar modelos de inteligencia artificial, pero sin pagar por ello.

El equipo del investigador también desarrolló otra herramienta, Glaze, que permite a los artistas enmascarar su estilo personal para evitar que las empresas de inteligencia artificial lo copien. “Funciona de forma similar a Nightshade: cambiando los píxeles de las imágenes de formas sutiles que son invisibles para el ojo humano, pero manipulan los modelos de aprendizaje automático para interpretar la imagen como algo distinto de lo que muestra en realidad”, describe MIT Technology Review.

Los investigadores buscan que Nightshade sea de código abierto para permitir que terceros lo puedan utilizar y crear sus propias versiones de la herramienta, a fin de que ésta sea más potente, de mayor alcance y equilibre el terreno que hoy está plenamente en favor de las grandes compañías de inteligencia artificial generativa.

“Nightshade aprovecha una vulnerabilidad de seguridad de los modelos generativos de IA, derivada del hecho de que se entrenan con grandes cantidades de datos (en este caso, imágenes que se han obtenido de internet). Nightshade manipula esas imágenes”, informó el medio estadounidense.

Y añadió: “los artistas que quieran compartir sus obras a internet, pero no quieran que las empresas de IA rastreen sus imágenes pueden subirlas a Glaze y optar por enmascararlas con un estilo artístico distinto al suyo o utilizar Nightshade. Cuando los desarrolladores de IA obtienen más datos de internet con los que ajustar un modelo de IA existente o crear uno nuevo, estas muestras alteradas se cuelan en el conjunto de datos del modelo y provocan su mal funcionamiento”.

Para entender mejor:

Debate sobre IA generativa no solo tecnológico, también social: Unesco

Esto es costoso para las empresas de inteligencia artificial, ya que los datos envenenados son muy difíciles de eliminar porque requiere que las compañías los encuentren y eliminen uno por uno de forma minuciosa.

De acuerdo con MIT Technology Review, los investigadores probaron el envenenamiento de datos con los últimos modelos de Stable Diffusion y con un modelo de IA que entrenaron desde cero.

“Cuando alimentaron a Stable Diffusion con solo 50 imágenes envenenadas de perros y luego le pidieron que creara imágenes de perros, el resultado fue extraño: criaturas con demasiadas extremidades y caras caricaturescas. Con 300 muestras envenenadas, un atacante puede manipular Stable Diffusion para generar imágenes de perros que parezcan gatos”, apuntó el medio.

La técnica de envenenamiento de datos puede servir para usos malintencionados, admitió Zhao, pero matizó que los autores necesitarían miles de muestras envenenadas para infligir un dañor real a los modelos más grandes y potentes de inteligencia artificial generativa, ya que se entrenan con miles de millones de muestras de datos.

La revista buscó opiniones entre otros investigadores académicos que no participaron en el proyecto de Nightshade, como Junfeng Yang, profesor de informática de la Universidad de Columbia y experto en seguridad de los sistemas de aprendizaje profundo, quien consideró que la herramienta podría tener una gran repercusión si consigue que las empresas de inteligencia artificial respeten más los derechos de los artistas, por ejemplo, estando dispuestas a pagar derechos de autor.

¿Te gusta informarte por Google News? Sigue nuestro Showcase para tener las mejores historias